6. 知乎数据获取

数据获取的目的是,我们能从这个N个维度的数据中,初步判断出某个问题的难易度(对应9.1数据筛选)

数据在精不在多,过多的数据只会干扰判断

问题浏览量

问题关注量(知乎站内流量)

问题创建时间

回答数量

第1名赞数量

第1名回答字数

第1名回答时间

目前为止,我们需要的基础数据全部准备完毕,现在你应该得到了一个百度 + 知乎数据的关键词文件,good job!

如果你坚持到了这里,我相信,我会非常愿意认识你这样的朋友^_^

7. 数据分析

7.1 关键词分组

面对海量杂乱无章的数据,我们需要通过关键词分组的形式,将相关的关键词和其对应的问题页面聚集到一起

1)jieba分词

利用python-jieba模块,将每个关键词切分成N个词项(term),比如“流量高手”会被分词为“流量”+ “高手“,包含相同词项的词视为一组

2)词项去重

参考【5.1母词获取】的去重部分

3)词项数据计算

用每个词项去匹配关键词,并计算匹配结果的数量(词频)和可获取流量总和

SEO的朋友们可能有种熟悉的感觉,这种方式类似于搜索引擎的“倒排索引”,我们实际上就是以term为索引,归类了知乎URL

下面随便拿点演示数据:

7.2 人工分类

直接按词项分组是单纯从字符串角度上的分组,简单粗暴但缺乏语义关系

比如“炒股”和“股票”这两个特征应该属于金融类,但按词项分组就会变成两组,所以最后应该人工过一遍

分类完成后,将对应的词频和可获取流量总和相加,得到总数据

然后用思维导图/表格的形式记录,下面用思维导图示例

但是记住,不要为了分组而分组,没有明显相关性的词项不应该被分到一组,否则那是在给自己找麻烦

8. 问题筛选

8.1 数据筛选

现在我们可以从可获取流量最多的类别中选取一个词项,在我们完成【6-7】后的关键词文件里,使用Bash shell 或者 在Excel-csv里搜索“关键词列”,找出包含这个词项的关键词,然后用指标来筛选,下面给出几个筛选数值仅做参考

问题浏览量(辅助)

问题关注量(辅助)

问题创建时间(辅助)

回答数量 <=50

第1名赞数量 <= 100

第1名回答字数 <= 800

第1名回答时间 (辅助)

可获取流量 >= 100

说一个场景,经过硬性指标筛选后,如果一个问题页面的浏览量远低于可获取流量,关注量少,问题创建时间为最近,第一名回答时间为最近,那么这类问题需要重点mark一下

但是why?朋友们不妨自己思考一下

好啦我来告诉你,每一类人群的数量是有限的,如果把上面的条件反回来,那么很可能你已经miss掉一部分流量,所以我们要有抢占先机的意识

筛选完成后,可按照【可获取流量】或【第1回答赞同数量】等条件降序排序,蓝海问题一目了然

8.2 人工筛选

人工主要来解决数据判断不了的内容问题,即第1名的回答是否未满足问题需求,主要找以下2种类型:

1)直接满足,但用户的隐含需求未被满足,存在扩展空间

举例

Q:“汽车多久保养一次”

A:“我一般一季度保养一次”

A(new):“不同品牌的汽车保养时间不同,我下面列出所有品牌xxx,保养项目xxx,机油选择xxx,保养什么坑xxx”

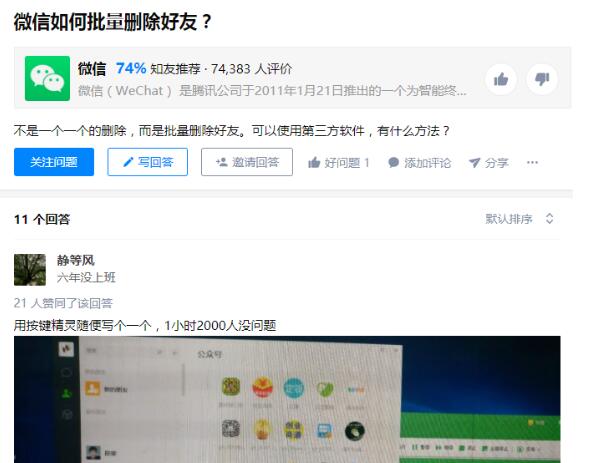

2)间接满足

正好翻到一个,上图

回答说明了按键精灵,但并没有给出这个脚本怎么写

相信到了这里,你已经找到了N个类别的N个问题,然后马上开始分析问题 > 列大纲 > xxxx…..

Stop!请立刻停止你的上头行为,我们还有最后一步

9. 流量跟踪

万里长征最后一步,非常重要,非常重要,非常重要

我们前面提到2点:

在百度推广后台-关键词规划师中,流量的数据口径是月,并且是预估值

SEO的网页排名是动态的

这就可能造成结果的不稳定性,辛辛苦苦做了数据,写了回答,搞了排名,结果却没有阅读量?

所以我们要监控页面的浏览量是怎样增长的,来确定这个页面是否真的获取了流量,能获取多少流量,最终判断要不要回答这些问题

监控时间单位可以是天,细致点可以每N个小时,监控时长大家自己判断,当然越长越准确

举个例子,假设某个问题的可获取流量为15W,那么平均每天的可获取流量为5000左右,那么3天(不考虑节假日)的可获取流量为1.5W

记录该页面的浏览量并且对比,只要上下浮动不是特别大,那么就可以列入我们的回答清单

10.最后

我们将视角提升到整个营销的层面,会发现蓝海流量获取是整个营销环节的第一步,其他部分诸如回答排名 & 流量路径 & 变现等

还有很多方法技巧类能帮助我们更好的利用蓝海流量,比如数据交叉计算,进阶玩法等

但是要将上面说的展开,又是很大一部分内容,受时间和精力所限,我们下次再讲

作者:CashWar 公众号:TACE

2000万的知乎蓝海流量掘金机会(上)

2000万的知乎蓝海流量掘金机会(中)

2000万的知乎蓝海流量掘金机会(下)

来源【运营官微圈】自媒体,更多内容/合作请关注「辉声辉语」公众号,送10G营销资料!